Dieses Jahr war ich nun schon zum zweiten Mal bei der SEO Campixx – dem Klassentreffen der SEOs. Ich bin bereits am Mittwoch Abend angereist, da ich vorher noch die Contentixx besucht habe. Meinen Contentixx Recap findet ihr beim SEO-Portal, bei dem ich das Ticket gewonnen hatte.

Wahrscheinlich ist das Hotel am Müggelsee nur zur Campixx Zeit so gut ausgebucht, denn die Lage ist abseits des Stadtzentrums, was für die Konferenz allerdings sehr praktisch ist, denn so bleibt man abends zusammen. Auch wenn die SEO Campixx erst am Samstag begonnen hat, konnte man schon Freitagabend zahlreiche Ankömmlinge an der Hotelbar oder beim Pokern antreffen. Bis in die Nacht hinein konnte man sich mit den Teilnehmern austauschen. Samstagmorgen ging es dann mit der Eröffnung los – Cheerleader und eine Vorstellung der Speaker à la Germany’s Next Topmodel. Danach dann noch eine Keynote in der es um die verschiedenen Menschentyp ging. Mehr zu den anderen Sessions des Tages findet ihr weiter unten. Abends gab es dann wieder viel Programm: Zum einen gab es „The Challenge“ und zum anderen mehrere Team Escape Slots. Ich habe nur beim Team Escape teilgenommen und was soll ich sagen: Mein Team war das einzige Team des Abends, das es aus dem Bus (The Traveller) geschafft hat (JUHU!). Danach hat der DJ das Publikum noch ordentlich eingeheizt und es wurde getanzt, getrunken und geredet. Am Sonntagmorgen fiel es dann nicht mehr ganz so leicht, aus den Federn zu kommen, aber durch die guten Talks ist man dann relativ schnell wach geworden und hat gespannt zugehört. Ich habe den Tag leider nicht mehr komplett mitgenommen, sondern bin gegen 15 Uhr wieder nach Hamburg losgedüst, aber es war trotzdem ein sehr interessanter Tag.

Hier nun aber zum spannenden Teil – dem Inhalt der Talks:

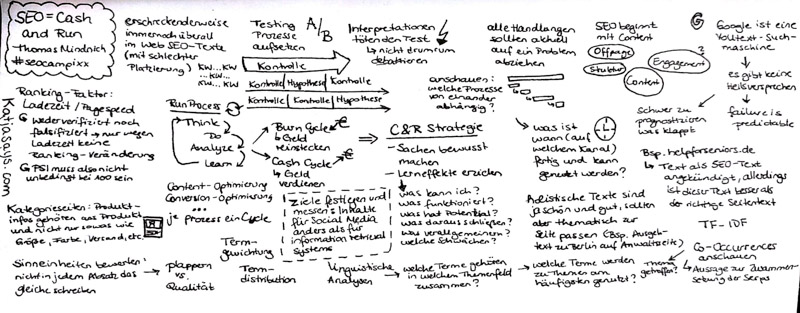

SEO = Cash + Run

Thomas Mindnich

Erschreckenderweise gibt es noch immer zahlreiche SEO-Texte im Internet, die Webseiten aber eigentlich gar nicht brauchen, da Texte für Suchmaschinen nicht mehr geschrieben werden sollten. Um die Effektivität neuer Features / Content-Platzierungen etc. zu testen, sollte man A/B Tests machen. Dabei sollte man allerdings nicht vergessen, zu unterschiedlichen Momenten zu testen, um eventuelle Zufälligkeiten im Verhalten zu umgehen und auf Nummer sicher zu gehen. Man sollte nicht vergessen, dass Google eine Volltext-Suchmaschine, also ein Information Retrieval System ist. Für SEO kann man keine Erfolge prognostizieren (und somit auch keine Heilsversprechen geben), denn nur Misserfolge sind vorhersehbar. Man kann also sagen, wie es nicht funktionieren wird, aber ob etwas funktioniert wird die Zeit zeigen. Wo früher Texte mit einer hohen Vorkommnis des Keywords noch gut waren, sind heute holistische Texte in aller Munde. Diese Texte sollten thematisch passend sein. Eine Anwaltsseite aus Berlin kann einen noch so schönen Text über Berlin und dessen Ausgeh-Möglichkeiten haben, aber nützen tut es ihr nichts, denn: Was hat das mit Anwälten zu tun? Die Geschwindigkeit einer Webseite soll ein Rankingfaktor sein. Thomas und sein Team konnten dies weder bestätigen noch widerlegen. Experimente mit der Seitengeschwindigkeit haben weder zu einer Verbesserung noch zu einer Verschlechterung im Ranking geführt. Daher sollte man im Zweifel nicht unbedingt mit allen Mitteln versuchen, in den Page Speed Insights auf den Wert 100/100 zu kommen, wenn es einem um gute Rankings geht. Als SEO sollte man sich überlegen was man kann, was funktioniert, wo es Schwächen geben könnte, was Potential hat und was man daraus schließen kann. Wenn man all dies beantworten kann, dann kann man mit seiner Strategie Erfolg haben. Mehr Infos in der Sketchnote:

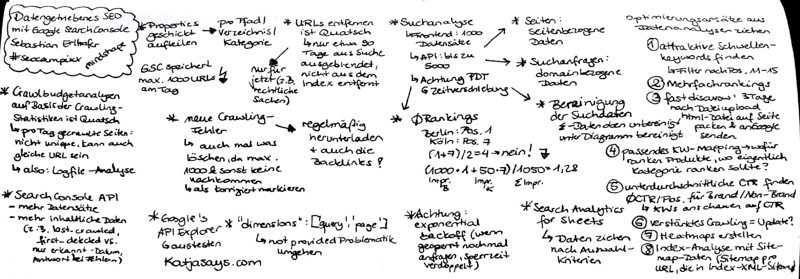

Datengetriebenes SEO mit der Google Search Console

Sebastian Erlhofer

In seinem Vortrag konnte Sebastian zahlreiche Tipps geben, was man alles aus den Daten der Google Search Console holen kann:

- Properties geschickt aufteilen für mehr Daten: pro Pfad / Verzeichnis / Kategorie

- Achtung: URLs entfernen blendet die URLs nur für 90 Tage aus der Suche aus, sie werden nicht aus dem Index entfernt

- Suchanalyse: Im Frontend bekommt man max. 1000 Datensätze, über die API können es 5000 werden. Achtung: Zeitverschiebung, die Daten sind zur PDT gemessen

- Seiten: seitenbezogene Daten

- Suchanfragen: domainbezogene Daten

- Durchschnittliche Rankings: Bsp. Berlin: Pos. 1, Köln: Pos. 7 – nicht: (1+7)/2 = 4, sondern: (1000 Impressions Berlin * 1 + 50 Impressions Köln * 7)/1050 Gesamtimpressions = 1,28

- Achtung: Bereinigung der Suchdaten. Die Zusammenfassung oben ist unbereinigt, die Daten unter dem Diagramm sind bereinigt

- Search Analytics for Sheets: Damit kann man sich automatisch Daten ziehen

- neue Crawling-Fehler: sollte man auch mal löschen, da es max. 1000 Einträge gibt und keine nach kommen, wenn die Liste voll ist

- Crawling-Fehler und Backlinks: regelmäßig herunterladen für mehr Daten

- Crawling-Statistiken: Damit auszuwerten, wie viele Seiten der Googlebot pro Tag besucht, macht keinen Sinn, da die Seiten hier nicht unique sind – also: Logfile-Analyse machen

Aus den Datensätzen, die man aus der Search Console ziehen kann, kann man viele Optimierungsansätze ziehen:

- attraktive Schwellenkeywords finden (Filter nach Pos. 11-15)

- Mehrfachrankings identifizieren

- fast disavow: 3 Tage nach Einreichen der Disavow-File die URLs als HTML-File auf die Seite packen und bei Google einreichen

- passendes Keyword-Mapping: Wofür ranken Produkte, wo eigentlich Kategorien ranken sollten

- unterdurchschnittliche CTR finden (durchschnittliche CTR pro Position für Brand/Non-Brand berechnen und Keywords anschauen auf CTR-Basis)

- verstärktes Crawling: könnte man ggf. auf ein Update schließen

- Heatmaps erstellen

- Index-Analyse mit Sitemap-Daten (Sitemap pro URL anlegen und diese dann in einer Index-XML-Sitemap speichern und an Google senden)

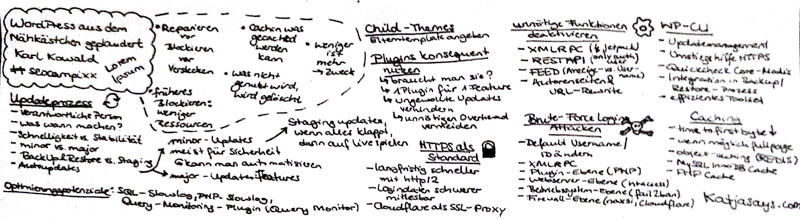

WordPress aus dem Nähkästchen geplaudert

Karl Kowald

Generell gilt:

- Reparieren vor Blockieren vor Verstecken

- früheres Blockieren kostet weniger Ressourcen

- cachen was gecached werden kann

- was nicht genutzt wird, wird gelöscht

- weniger ist mehr -> Zweck

Updateprozess

- verantwortliche Person festmachen

- was ist wann zu machen?

- Schnelligkeit vs. Stabilität

- major vs. minor

- BackUp & Restore vs. Staging

- Autoupdates (besser: nur für minor-Updates)

Plugins konsequent nutzen

- braucht man das Plugin wirklich

- ein Plugin für ein Feature

- ungewollte Updates verhindern

- unnötigen Overhead vermeiden

unnötige Funktionen deaktivieren

- XMLRPC (Achtung: Jetpack)

- RESTAPI (nur auth-user)

- FEED (Anzeige- vs. User-Name

- Autorenseiten und URL-Rewrite

WP-CLI

- Updatemanagement

- Umstiegshilfe HTTPS

- Quickcheck Core-Modis

- Integration in BackUp/Restore-Prozess

- effizientes Toolset

HTTPS als Standard

- langfristig schneller mit http/2

- Logindaten schwerer mitlesbar

- Cloudflare als SSL-Proxy

- Zertifikate auch via Let’s Enscrypt möglich

Brute-Force Login-Attacken

- Default User-Name/ID ändern

- Plugin-Ebene: PHP

- Webserver-Ebene: htaccess

- Betriebssystem-Ebene: fail2ban

- Firewall-Ebene: naxso, Cloudflare

Caching

- time to first byte reduzieren

- wenn möglich fullpage

- object-caching (REDIS)

- MySQL InnoDB Cache

- PHP Cache

Die Kunst digitaler Verführung

Karl Kratz

Wenn man eine Webseite betreibt, sollte man sich fragen: Wie lenkt man die Aufmerksamkeit so, dass in der Wahrnehmung des Besuchers eine bestimmte Realität entsteht? Wir sind Architekten, die in dem Nutzer ein „Das bin ja ich“ und „Das will ich haben“ Gefühl wecken wollen. Damit müssen wir die Aufmerksamkeit des Nutzers auf der Seite lenken, ihn führen und damit auch verführen. Man sollte auf Ereignisse optimieren, die den Kontext verändern und nicht einfach nur stumpf auf Keywords. Alle Ereignisse finden in einem bestimmten Kontext statt und erzeugen gleichzeitig einen neuen Kontext. Das heißt, dass man eine Konversion durch den Nutzer nur dann erzielt, wenn dieser eine Emotion und damit auch Resonanz verspürt. Die Nutzer wissen oftmals gar nicht was sie brauchen, sondern nur, was ihnen gerade passiert ist oder was für ein Problem sie gerade haben. Man muss eine Erwartung aufbauen und bestimmte Gefühle in ihnen erwecken. Die Frage ist doch: Erzeugt man in den Nutzern eine neue Realität? Möchte man in einem Hundeshop nach den Standardfiltern wie Größe, Farbe oder Preis filtern oder lieber nach Eigenschaften wie Treue oder Familientauglichkeit? Am besten wäre es, wenn man den Nutzer entscheiden lässt, was er machen möchte und ihm daraufhin dann passende Produkte zeigt.

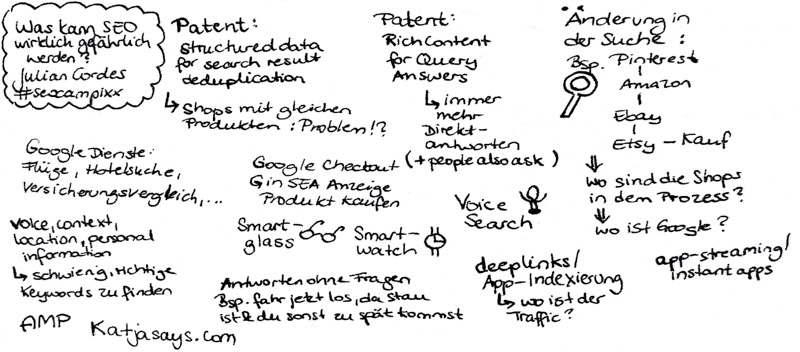

Was kann SEO wirklich gefährlich werden?

Julian Cordes

Noch vor einiger Zeit hat Julian geschrieben, dass SEO tot ist, doch SEO ist nur nach früherem Sinne tot und heutzutage einfach anders. In dieser Session wurde darüber gesprochen, was SEO alles gefährlich werden könnte. Hier die Punkte zusammengefasst:

- Patent: structured data for search result deduplication – Shops mit gleichen Produkten könnten problematisch werden

- Patent: rich content for query answers – immer mehr Direkt-Antworten in Google

- Änderungen im Suchverhalten der Nutzer: Shops und Google werden manchmal gar nicht in den Suchprozess integriert, da Nutzer gerne mal direkt zu Amazon oder Ebay gehen

- deeplinks/app indexing

- app streaming/instant apps

- voice search

- smartglass/smartwatch

- Antworten ohne Fragen: z.B. fahre jetzt los, denn es ist Stau und du kommst sonst zu spät zur Arbeit

- Google Checkout: direkt in SEA Anzeige Produkte kaufen

- Google Dienste: immer mehr direkt in Google machbar (Wetter sehen, Flüge buchen, Hotelsuche, Versicherungsvergleich)

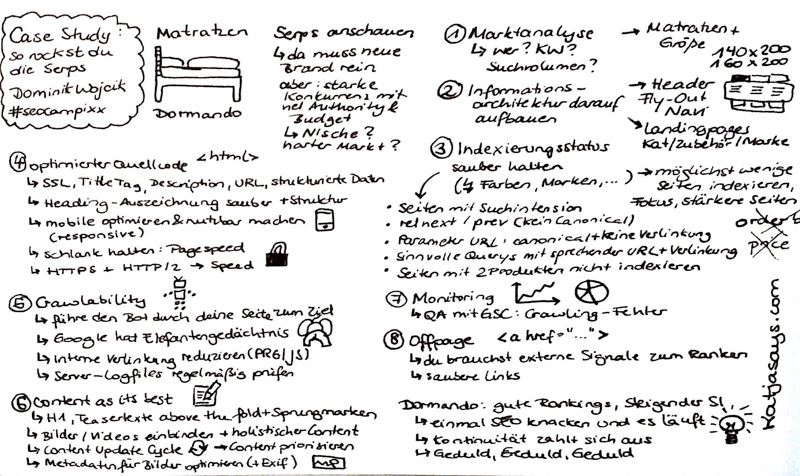

Case Study: So rockst du die Serps

Dominik Wojcik

Dominik hat am Beispiel von Dormando vorgestellt, wie man eine Webseite zum Erfolg und guten Rankings bringen kann. Die Schritte dabei sind:

1. Marktanalyse

- wer ist auf dem Markt

- welche Keywords sind relevant

- welches Suchvolumen gibt es

2. Informationsarchitektur

- auf Markt- und Keywordanalyse aufbauen

- z.B. Landingpages zu bestimmten Themen

- z.B. Art der Navigation (Fly Out)

3. Indexierungsstatus sauber halten

- Seiten mit Suchintention

- rel next/prev ohne Canonical

- Parameter URL: Canonical und keine Verlinkung

- sinnvolle Querys mit sprechender URL und Verlinkung

- Seiten mit 2 Produkten nicht indexieren

- möglichst wenige Seiten indexieren

4. Optimierter Quellcode

- SSL, Title Tag, Description, URL, strukturierte Daten

- HTTPS + HTTP/2 -> Speed

- schlank halten: Pagespeed

- Heading-Auszeichnung sauber + Struktur

- mobile optimieren und nutzbar machen

5. Crawlability

- Bot durch die Seite zum Ziel führen

- Google hat Elefantengedächtnis

- interne Verlinkung reduzieren (PRG, JS)

- Server-Logfiles regelmäßig prüfen

6. Content as its best

- H1, Teasertexte above the fold + Sprungmarken nach unten

- Bilder / Videos einbinden

- Content Update Cycle (nach Priorisierung)

- Metadaten (+Exif) für Bilder optimieren

7. Monitoring

- Qualitätssicherung mit der Google Search Console: Crawling-Fehler

8. Offpage

- externe Signale zum Ranken notwendig

- saubere Links

Bei Dormando haben all diese Schritte dazu geführt, dass der Sichtbarkeitsindex steigt und gute Rankings vorhanden sind. Geduld zahlt sich aus und man muss kontinuierlich an der Seite arbeiten. Wenn man einmal SEO geknackt hat, dann läuft es.

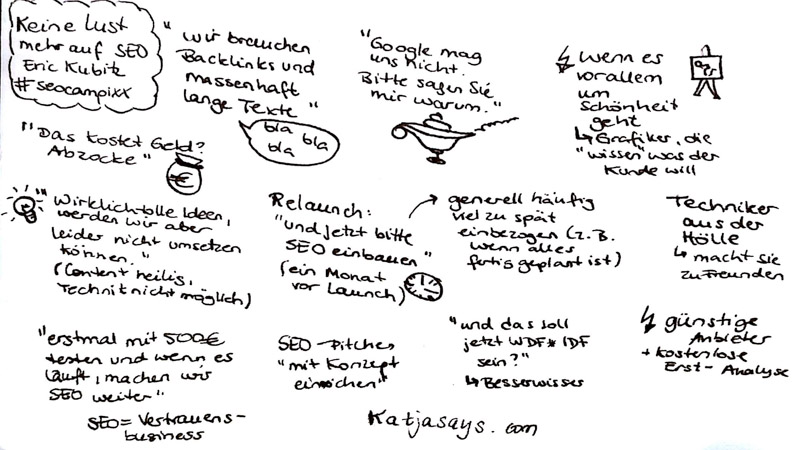

Keine Lust mehr auf SEO

Eric Kubitz

In diesem Vortrag wurde bestimmt mit mindestens einem Punkt aus der Seele eines jeden SEO gesprochen. Die witzigsten Aussagen von Kunden, die einen SEO zur Weißglut bringen, hier in der Übersicht:

- Wir brauchen Backlinks und massenhaft lange Texte

- Google mag uns nicht, bitte sagen Sie mir warum

- Das ist schön und der Kunde mag das so (wenn Grafiker alles besser wissen)

- Relaunch: und jetzt bitte SEO einbauen (und das kurz vor Livegang)

- Das kostet Geld? Abzocke

- Wir starten erstmal mit 500 Euro, testen das aus und wenn es läuft, dann machen wir weiter mit SEO

- Und das soll jetzt WDF*IDF sein (Klugscheisser)

Ich hatte sehr viel Spaß bei der SEO Campixx und konnte einige Anstöße für mich mitnehmen. Nicht nur die Talks waren spannend (und teilweise mit einem Augenzwinkern), sondern auch die Gespräche mit anderen Konferenz-Teilnehmern waren einfach super. Auch die ein oder andere neue Person konnte man kennenlernen und direkt neue Kontakte knüpfen. Ich hoffe, ihr hattet auch viel Spaß bei der Konferenz. Wenn ihr noch mehr Infos aus den Talks habt, die ihr teilen wollt, schreibt gerne einen Kommentar.

[…] Katja von katjasays.de […]

Cooles Recap, wird gleich im Meetup natürlich erwähnt 😀

Für mich total gut, alle Slots zu denen du was schreibst hab ich nicht besucht!

[…] Katjasays.com – schön mit den eigenen Notizen als Sketchnode […]

[…] https://www.katjasays.com/seo-campixx-2017-recap/ […]

Danke für die Zusammenfassung!

[…] Katjasays […]

Liebe Katja, all Deine Recaps betreffen Sessions, bei denen wir nicht waren. Daher ein doppeltes Dankeschön von uns. Gruß Achim Kilgus, Webmanager GMBH. Unsere Recaps findet Ihr unter https://www.webmanager.net/2017/03/seo-campixx-2017-short-recap-der-webmanager-gmbh/ – Viel Spass beim Lesen.

[…] Katjasays […]

[…] Katjasays […]

[…] Katjasays.com – Schön mit den eigenen Notizen als Sketchnode […]