Die SEO Campixx 2018 war zugleich das 10. Jubiläum des „SEO-Klassentreffens“ und für mich auch mein drittes Mal. Wie gewohnt fand sie im Hotel Müggelsee Berlin statt und lockte zahlreiche SEOs aus ganz Deutschland an. Eines vorweg: Für mich war es das erste Mal, dass ich dort einen Talk halten durfte und es war großartig.

Bei der SEO Campixx geht es natürlich um spannende Vorträge, neue Insights und den Erfahrungsaustausch, aber vor allem auch ums Netzwerken. Mit einem sagenhaften Rahmenprogramm wird einem dieses noch einfacher gemacht und der Abend wird für niemanden langweilig. So konnte man in diesem Jahr seine Iris fotografieren lassen, VR erleben, Lach-Yoga ausprobieren, an einem Exit-Game teilnehmen oder beim Karaoke mitsingen. Ein Highlight war die Band United Four, die mit ihrem Live-Act die Menge zum Toben brachte und viel Stimmung aufkommen ließ. Für wen das alles zu viel des Guten war, konnte es sich in der Captain’s Bar gemütlich machen und den ein oder anderen Plausch bis tief in die Nacht halten.

Auch wenn leider einige Speaker krank waren und daher spannende Talks ausfallen mussten, hat das Programm so einiges geboten. Die Talks, die ich mir angehört habe, habe ich wie gewohnt für euch zusammengefasst und mit Sketchnotes versehen:

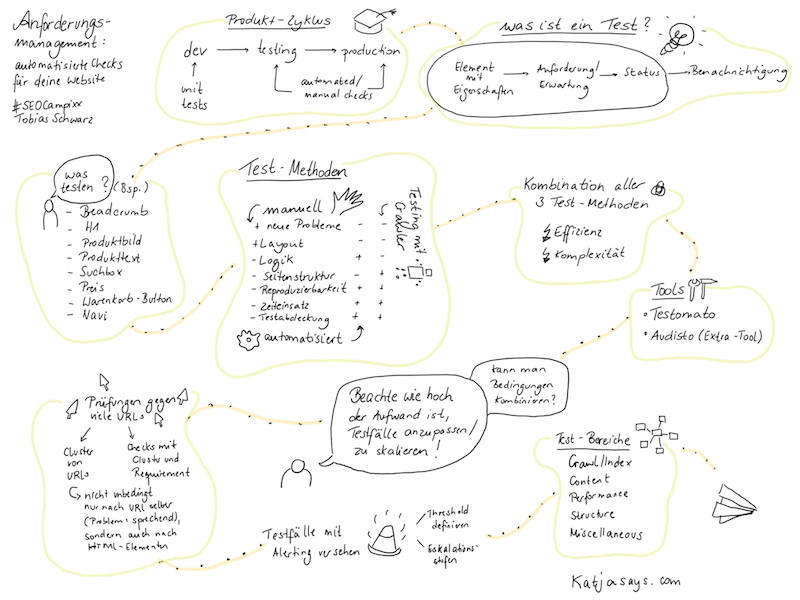

Anforderungsmanagement: automatisierte Checks für deine Website

Tobias Schwarz

Ein Produkt bewegt sich aus der Development- in die Testing- und schließlich in die Production-Umgebung. Dabei werden in der ersten Phase Unit-Tests geschrieben und in den beiden weiteren sollten manuelle und automatisierte Checks hinzu kommen. Ein Test besteht dabei aus einem Element mit einer Eigenschaft, einer Anforderung/Erwartung, einem dazugehörigen Status und er resultiert letztendlich in einer Benachrichtigung. Am besten ist es, wenn man manuelles, automatisiertes und automatisiertes Testen mit einem Crawler mit einander kombiniert. Da man dabei stark auf Effizienz achten sollte und das leicht mal komplex werden kann, bietet es sich an, ein Tool zur Unterstützung zu nutzen. Bei der Auswahl des Tools sollte man auf jeden Fall darauf achten, wie hoch der Aufwand dafür ist, einen Testfall anzupassen bzw. zu skalieren und ob man Bedingungen mit einander kombinieren kann. Bereiche, in die man die Tests unterteilen kann, sind Crawl/Index, Content, Performance, Structure und Miscellaneous.

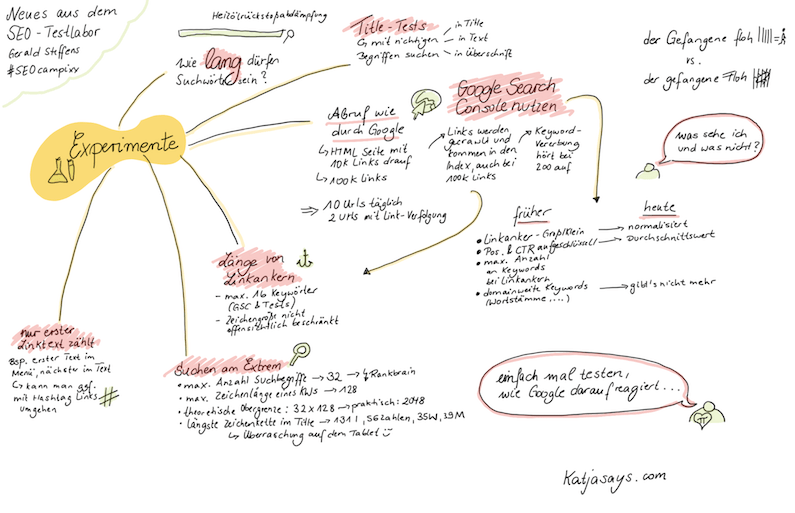

Neues aus dem SEO-Testlabor

Gerald Steffens

Gerald hat bereits diverse SEO-Experimente durchgeführt und konnte daraus viele Erkenntnisse sammeln. Einige davon sind diese hier:

- Abruf wie durch Google: bei der Einreichung einer HTML Seite mit 100.000 Links wurden alle dieser Seiten indexiert, die Keyword-Vererbung hört allerdings bei 200 auf

- Länge von Linkankern: maximal 16 Wörter, Zeichengröße nicht offensichtlich beschränkt

- Linktexte: nur der erste Linktext zählt, auch wenn dieser z.B. im Menü steht – umgehen kann man das ggf. mit Anker-Links

- Suchen am Extrem: maximal 32 Suchbegriffe möglich, maximale Zeichenlänge eines Keywords ist 128, Obergrenze: 2048 Zeichen, längste Zeichenkette im Title: 131 „l“, 56 Zahlen, 35 „W“ oder 39 „M“

Crawling analysis to the fullest

Johannes Giesche, Eduard Protzel

Das Crawling Budget setzt sich aus dem Bedarf (wie viele Seiten sollen gecrawlt werden) und der Frequenz (Häufigkeit des Crawlens) zusammen und es steht für die Uptime/den Verbrauch eines Servers. Da effizientes Crawlen sehr wichtig ist, sollte man das Crawler-Verhalten auf seiner Webseite analysieren. Dabei schaut man sich diese drei Bereiche an:

- Accessibility: Google Cache, robots.txt, Abruf wie durch Google

- Fehler-Analyse: Sitemap, Crawling-Fehler

- Tool-Analyse: Simulation, Logfile-Analyse

Die Unterschiede zwischen simulierten Crawling-Analysen (z.B. durch Screaming Frog oder DeepCrawl) und Logfile-Analysen könnt ihr euch in der Sketchnote genauer ansehen. Die Logfiles müssen für die Weiterverarbeitung aufbereitet werden. Dafür filter man am besten nach der IP-Adresse des Googlebots und zerlegt die Daten dann in Excel. Mit Hilfe von BigQuery kann man sie dann ins Google Data Studio importieren, wo man sie interaktiver analysieren und mit Segmenten versehen kann. Learnings von Johannes und Eduard sind:

- Achtung: URL-Fingerprinting

- was wie ein HTML-Link aussieht, wird gecrawlt

- Achtung: Ressourcen, die Seiteninhalt nicht ändern

- nach Relaunch: Logfile-Analyse sinnvoll

- Ladezeitoptimierung lohnt sich immer

- Non-HTMLs beachten (z.B: X-Robots-Tag)

- 301 nicht immer richtig, manchmal können Inhalte einfach weg

- Qualität vs. Quantität

- Ballast sollte gelöscht werden

- mutig sein bei der robots.txt

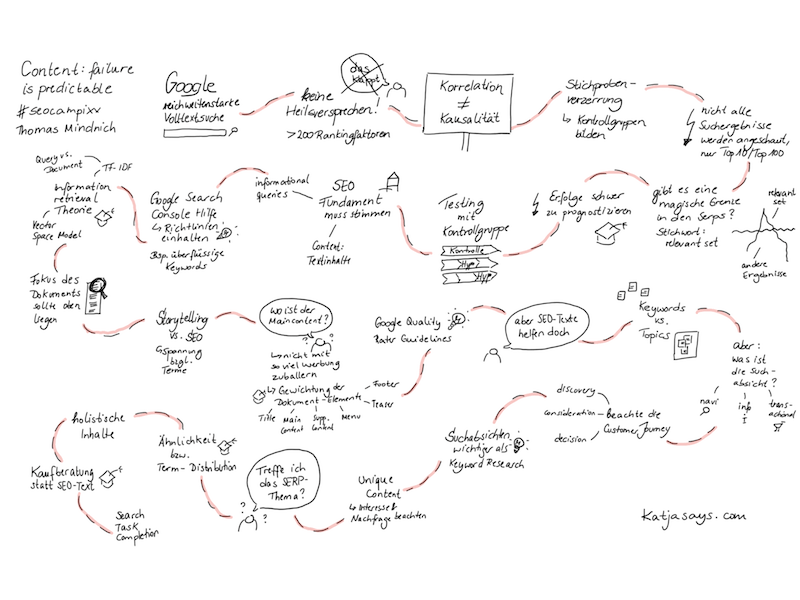

Content: failure is predictable

Thomas Mindnich

Google ist eine reichweitenstarke Volltext-Suchmaschine. Da es mehr als 200 Rankingfaktoren gibt, gibt es kein Heilsversprechen, welche Maßnahmen ein besseres Ranking erzielen und welche nicht. Man sollte auch vorsichtig sein, wenn man aus Korrelation Kausalität ableiten möchte. Problematisch ist es, dass viele sich nur die Top 10/Top 100 des Suchergebnisses anschauen, dabei oftmals aber vielleicht nur das „relevant set“ von Google, also die Spitze des Eisbergs, sehen und nicht, was unterhalb der Wasseroberfläche gibt. Eine genaue Analyse ist dabei nur schwierig möglich. Auch vergessen viele beim Testen die Kontrollgruppe, wodurch eine Stichproben-Verzerrung entstehen kann. Erfolge mit Content-Optimierung sind daher nur schwer vorherzusagen, man kann eher sagen, was nicht klappen wird.

Nichtsdestotrotz hat Thomas noch einige Tipps mit auf den Weg gegeben:

- SEO-Fundament muss stimmen

- Google Search Console Richtlinien sollten eingehalten werden

- denke an die Information-Retrieval-Theorie

- Fokus des Dokuments sollte oben liegen

- Gewichtung der Dokument-Elemente sollte beachtet werden

- Google Quality Rater Guidelines sollten eingehalten werden

- Themen-Optimierung vs. keywordoptimierte Texte

- die Suchabsicht sollte einbezogen werden

- beachte die Customer Journey

- bei Unique Content solltest du das Interesse und die Nachfrage beachten

- Content muss das SERP-Thema treffen

- Kaufberatung statt SEO-Text

- behalte die Search Task Completion im Hinterkopf

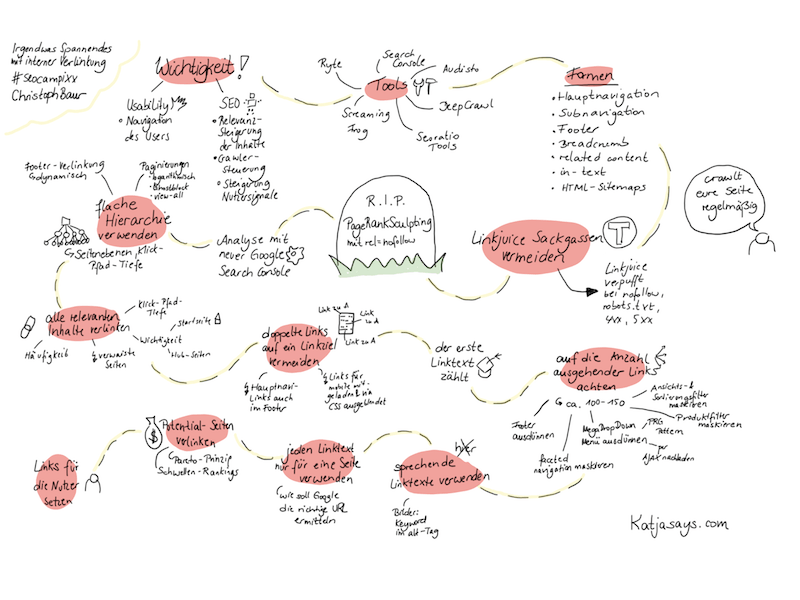

Irgendwas Spannendes mit interner Verlinkung

Christoph Baur

Interne Verlinkung ist nicht nur für die Usability (Navigation des Nutzers) wichtig, sondern auch für SEO (Relevanzsteigerung der Inhalte, Crawler-Steuerung, Steigerung der Nutzersignale). Tools wie Ryte, SeoRatioTools oder Screaming Frog können dabei helfen, die internen Links zu analysieren.

Formen der internen Verlinkung

- Hauptnavigation

- Subnavigation

- Footer

- Breadcrumb

- related content

- in-text

- HTML-Sitemaps

Tipps zur internen Verlinkung

- Linkjuice Sackgassen vermeiden: Linkjuice verpufft bei nofollow, robots.txt. Statuscode 4XX, Statuscode 5XX)

- flache Hierarchie verwenden: beachte die Seitenebenen und die Klick-Pfad-Tiefe, verwende dynamische Footer-Links und setze Paginierungen (logarithmisch, Ghostblock oder view-all) ein

- alle relevanten Inhalte verlinken: achte dabei auf Häufigkeit und Klick-Pfad-Tiefe sowie die Wichtigkeit der verlinkenden Seite (Startseite vs. Hubseite)

- doppelte Links auf ein Linkziel vermeiden: der erste Linktext zählt, Vorsicht bei Hauptnavi-Links, die auch im Footer zu finden sind, achte darauf, dass Links für die mobile Version nicht geladen und per CSS ausgeblendet werden

- auf die Anzahl ausgehender Links achten: 100-150 sind im Durchschnitt ok, Maßnahmen sind Footer und MegaDropDown-Menü (mit PRG oder Ajax) ausdünnen, faceted navigation maskieren und Ansichts-, Sortierungs und Produkt-Filter maskieren

- sprechende Linktexte verwenden: bei Bildern kannst du Keywords im alt-Tag verwenden

- jeden Linktext nur für eine Seite verwenden: wie soll Google sonst die richtige URL zum Keyword ermitteln

- Potential-Seiten verlinken: verlinke nach dem Pareto-Prinzip, viel Potential steckt in Seiten mit Schwellen-Rankings

- Links für die Nutzer setzen

Wie ihr seht, gab es viele unterschiedliche und spannende Themen bei den Vorträgen. Welche haben euch besonders gut gefallen?

Wer sich auch mit anderen SEOs in lockerem Umfeld austauschen und die neuesten SEO-Trends kennenlernen möchte, sollte bei der nächsten SEOCampixx dabei sein. Bei keiner anderen SEO-Konferenz kann man so leicht mit anderen Teilnehmern ins Gespräch kommen. Auch ich konnte mal wieder mit vielen Bekannten sprechen sowie neue Leute kennenlernen und freue mich schon auf das nächste „SEO-Klassentreffen“.

Hallo Katja,

ein TOP Recap, wie immer!

Danke für die coole Zusammenfassung!

LG

Janna

[…] Katjasays […]

[…] Katjasays […]

[…] KatjaSays (Hamburg) Marketing Factory Blog (Düsseldorf) Sebastian Blum (Zolling) clicks (Dresden) Webneo (Dresden) ADCANDA (Bentwisch) spacedealer (Berlin) Zimmermanns Internet PR-Beratung (Dresden) Elbcontent (Hamburg) […]

[…] Katjasays […]

[…] KatjaSays (Hamburg) Marketing Factory Blog (Düsseldorf) Sebastian Blum (Zolling) clicks (Dresden) Webneo (Dresden) ADCANDA (Bentwisch) spacedealer (Berlin) Zimmermanns Internet PR-Beratung (Dresden) Elbcontent (Hamburg) […]